MMIM(2021 EMNLP)分级互信息最大化

论文题目(Title):Improving Multimodal Fusion with Hierarchical Mutual Information Maximization for Multimodal Sentiment Analysis

研究问题(Question):提出了一个名为 (MMIM),它在层次上最大化互信息(MI)在单模态输入对(多模态间)和多模态融合结果与单模态输入之间,以便通过多模态融合保持任务相关信息。

研究动机(Motivation):以前的工作要么反向传播任务损失,要么操纵特征空间的几何属性来产生良好的融合结果,这忽略了保存从输入到融合结果的关键任务相关信息。

主要贡献(Contribution):

1. 提出了一种用于多模态情感分析的分层MI最大化框架。MI最大化发生在输入级和融合级,以减少有价值的任务相关信息的损失。

2. 框架中制定了计算细节来解决棘手的问题。该公式包括参数学习和非参数GMM两部分,具有稳定光滑的参数估计。

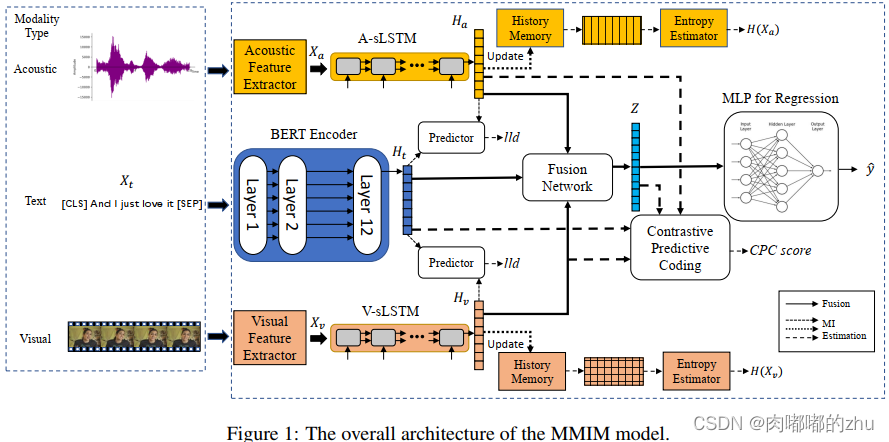

研究思路(Idea):输入为三个模态的序列(文本、视频、语音),输出为表示情感强度值y。首先使用特征提取器(视频、语音)和tokenizer(文本)将原始输入处理为数字序列向量。然后包括特征融合和最大互信息两个部分。

研究方法(Method):

研究过程(Process):

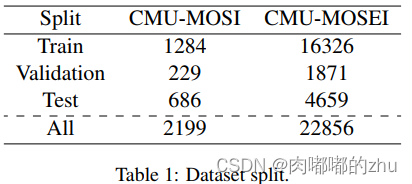

1.数据集(Dataset)

2.评估指标(Evaluation)

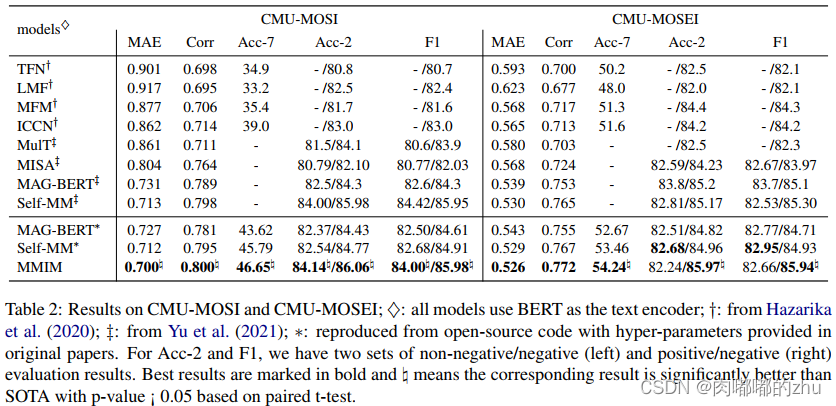

mean absolute error (MAE),Pearson correlation (Corr),seven-class classification accuracy (Acc-7),binary classification accuracy (Acc-2), F1 score

3.实验结果(Result)

总结(Conclusion):在两个数据集上进行了综合实验,随后进行了消融研究,结果验证了我们模型的有效性和MI最大化框架的必要性。我们进一步可视化了损失,并展示了一些有代表性的例子,以更深入地了解我们的模型。我们相信这项工作可以激发未来在表征学习和多模态情感分析方面的创造力。